Из жизни, Интернет, Нейронки

Из жизни, Интернет, Нейронки  Написать комментарий

Написать комментарий GPT: нейросеть, которая может написать все, что угодно. Или почти все…

Нейросети - это программы, которые используются для обработки больших объемов данных и решения различных задач с помощью имитации работы человеческого мозга. Нейросети способны самообучаться и улучшать свою точность с течением времени.

Существует множество видов нейросетей, которые применяются в разных областях, таких как распознавание лиц, моделирование и прогнозирование, генерация изображений и текстов, игры и многое другое. Из преимуществ нейросетей - это их высокая скорость, гибкость, адаптивность и способность обрабатывать неструктурированные данные, из недостатков - сложность, требовательность к ресурсам, непрозрачность и возможность ошибок или злоупотреблений.

Вот некоторые известные нейросети:

LeNet-5 - это одна из первых сверточных нейросетей, которая использовалась для распознавания рукописных цифр на изображениях. Она состоит из 7 слоев: 2 сверточных, 2 субдискретизирующих (pooling), 2 полносвязных и 1 выходного. Всего в нейросети около 60 тысяч параметров (весов и смещений).1

AlexNet - это еще одна сверточная нейросеть, которая победила в соревновании по классификации изображений ImageNet в 2012 году. Она состоит из 8 слоев: 5 сверточных, 3 полносвязных и 1 выходного. Всего в нейросети около 60 миллионов параметров. Она также использует техники, такие как ReLU (rectified linear unit), dropout и data augmentation для улучшения производительности и предотвращения переобучения.

LSTM (long short-term memory) - это тип рекуррентной нейросети, которая способна обрабатывать последовательные данные, такие как текст или речь. Она состоит из повторяющихся модулей, которые имеют три вентиля (forget gate, input gate и output gate) для контроля потока информации между ячейками памяти. Всего в LSTM около 4n^2 + 8n параметров, где n - это размерность скрытого состояния.

GPT-3 (generative pre-trained transformer 3) - это одна из самых продвинутых нейросетей для генерации текста на естественном языке. Она основана на архитектуре трансформера, которая использует механизмы внимания (attention) для обработки контекста и зависимостей между словами. Она предварительно обучена на большом корпусе текстов из интернета и может адаптироваться к разным задачам и доменам с помощью нескольких примеров (few-shot learning). Всего в GPT-3 около 175 миллиардов параметров.

Это лишь некоторые примеры нейросетей с характеристиками. Существует еще много других видов и моделей нейросетей, которые можно изучать и применять для разных целей.

Сейчас идет хайп вокруг чата GPT.

GPT - это семейство моделей искусственного интеллекта для генерации текста на естественном языке, разработанных компанией OpenAI. Последняя версия, GPT-4, была представлена в марте 2023 года и является одной из самых продвинутых и мощных моделей в своей области. Она способна обрабатывать не только текст, но и изображения, а также решать разные задачи, такие как классификация, суммаризация, диалог, генерация кода и другие. Перспективы развития GPT моделей в будущем зависят от многих факторов, таких как технологический прогресс, этические принципы, экономические интересы и социальные потребности. Некоторые возможные направления развития GPT моделей могут быть следующими:

- Увеличение размера и мощности моделей. С каждой новой версией GPT количество параметров модели растет в геометрической прогрессии. Например, GPT-4 имеет около 175 миллиардов параметров, в то время как GPT-3 имела около 175 миллионов. Это позволяет моделям обучаться на больших объемах данных и генерировать более качественный и разнообразный текст. Однако такое увеличение требует больших вычислительных ресурсов и энергозатрат, а также может приводить к проблемам с безопасностью и ответственностью за результаты работы моделей.

- Улучшение качества и надежности моделей. Современные GPT модели все еще далеки от совершенства и могут допускать ошибки, логические несостыковки, фактические неточности или нежелательный контент. Для повышения качества и надежности моделей необходимо улучшать методы обучения, контроля и оценки моделей, а также учитывать этические и социальные аспекты работы с текстом на естественном языке. Например, можно использовать техники, такие как дополнение данных (data augmentation), регуляризация (regularization), дропаут (dropout), адверсариальное обучение (adversarial training), дистилляция (distillation) и другие.

- GPT модели уже сейчас используются в разных сферах деятельности, таких как образование, бизнес, наука, искусство, развлечения и другие. В будущем можно ожидать появления новых областей применения моделей или углубления существующих. Например, можно использовать GPT модели для создания персонализированного контента, для улучшения коммуникации между людьми и машинами, для поддержки творческого процесса, для анализа и синтеза информации.

Структурная схема GPT-4 может быть построена на основе описания модели в научной статье (отсюда - https://openai.com/research/gpt-4), а также на основе примеров работы модели на сайте OpenAI.

Вот один из возможных вариантов структурной схемы GPT-4 - Структурная схема GPT-4, нарисованная самим чатом GPT-4 (эта вариация чата рисовать не умела, поэтому попробовала отобразить текстом):

±--------------------+ ±--------------------+ | | | | | Image Encoder | | Text Encoder | | | | | ±--------------------+ ±--------------------+ | | | | ±---------±-------------+ | v ±--------------+ | | | Transformer| | | ±--------------+ | v ±--------------+ | | | Text Decoder| | | ±--------------+ | v ±--------------------+ | | | Text Output | | | ±--------------------+

Кроме GPT есть речевые модели BERT - это семейство моделей представления языка, которые используют двунаправленные трансформеры для обучения на больших корпусах неразмеченных текстов. Они способны решать различные задачи обработки естественного языка, такие как классификация текста, вопросно-ответные системы, извлечение именованных сущностей и т.д. Они также поддерживают многие языки, включая русский.

Основное отличие между моделями BERT и GPT заключается в том, что BERT - это двунаправленная модель, а GPT - однонаправленная. Это означает, что BERT может учитывать контекст слева и справа от текущего слова, а GPT - только слева. Это дает BERT преимущество в задачах понимания языка, таких как классификация текста или извлечение сущностей. GPT же лучше справляется с задачами генерации языка, такими как написание текстов или диалогов. Кроме того, BERT и GPT отличаются размером и объемом данных, на которых они обучались. GPT-3 намного больше BERT и обучался на миллиардах параметров. BERT требует более тонкой настройки на больших наборах данных для конкретных задач.

Напоследок критическое мнение чата GPT о самом себе от третьего лица: Однако он также имеет свои ограничения и риски. Он может давать неверные или бессмысленные ответы, быть чрезмерно многословным или повторяться. Он также может нарушать авторские права, этические нормы или конфиденциальность данных. Поэтому нужно быть осторожным при использовании чат-бота и не доверять ему слепо.

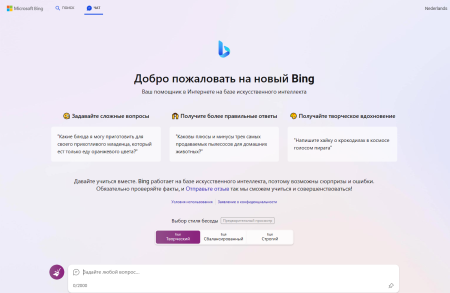

Хотите помучить чат GPT? Майкрософт выкатил его в открытый доступ.

Открываем браузер Edge, заходим в учетку майкрософта, открываем bing.com и на нажимаем в меню на ЧАТ и вот он, чат GPT, бесплатно и без ожидания:

А уже раздают доступ к GPT-5

P.S. Эту статью написал чат GPT.

Метки:

Метки:  admin

admin

Просмотров: 2 735

Просмотров: 2 735

Запись опубликована в 09:44

Запись опубликована в 09:44